20 erreurs à éviter pour les moteurs de recherche

Une bonne adéquation entre la qualité d'un site et ce que les moteurs veulent proposer aux internautes en réponse à leur recherche, c'est ce que doit chercher le webmaster.

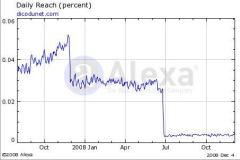

Or, que ce soit par maladresse ou par volonté de promouvoir artificiellement son site, un webmaster peut commettre des erreurs qui feront qu'au lieu de figurer en bonne place dans les pages de résultats, son site au contraire déclassé sera supprimé de l'index!

Voici la liste des choses qu'il faut absolument éviter sur un site web:

- Ne pas construire un site sur des frames.

Utiliser un frameset facilite la création d'un site de type "cours" ou l'on peut naviguer facilement dans les chapitres. Mais on obtient le même résultat avec un modèle dont seul le contenu rédactionnel change ou en propageant le menu entre pages entre un script comme Site Update. - Ne pas le construire tout en flash.

Le flash peut être utilisé à titre accessoire pour agrémenter le site, mais il est mal référencé par les moteurs et ne facilite pas l'indexation des pages. - Eviter les liens dynamiques.

Accéder au contenu par des liens en JavaScript vous fait perdre l'avantage des liens internes et peut empêcher l'indexation si une sitemap n'est pas construite par ailleurs. A moins que l'on ne veut empêcher l'indexation des pages. - Et le contenu dynamique.

Il en est de même du contenu qui est ajouté en Ajax dans les pages. Ce contenu n'est pas vu par les robots et n'est pas indexé. Ajax doit être réservé aux données fournies à la demande aux visiteurs. - Duplicate content.

Rendre une même page accessible aux robots, en plusieurs exemplaires, ou leur permettre d'accéder à une même page avec deux URLs différentes, ce qui revient au même pour les moteurs, fera que la page sera supprimée de l'index. Si une page est copiée sur un site différent, les moteurs supprimeront la plus récente ou celle qui a le moins de liens retours.

S'il y a trop de pages dupliquées, le moteur pensera que vous cherchez à bourrer son index et pénalisera le site. - Pas de texte caché.

Il y a plusieurs moyens de cacher du texte au visiteurs et le rendre visible aux robots, et ils sont tous prohibés. Que ce soit en utilisant des règles CSS qui placent le texte hors de la page visible, ou une couleur de texte identique à la couleur de fond, ces procédés sont repérés et le site pénalisé.

Google a déposé le brevet no 8392823 pour un système de détection de texte et liens cachés. - Affichages multiples.

Même si cela participe d'une intention légitime, comme par exemple sur un site bilingue présenter des pages différentes selon la langue du navigateur, il faut éviter de présenter aux robots un contenu différent de ce que voient les visiteurs. - Meta refresh.

Dans le même esprit mais de façon délibérée, utiliser la balise meta refresh pour présenter à l'internaute un contenu différent de ce que voient les robots est prohibé. - Pages en construction.

Laisser sur un site des pages en constructions qui soient accessibles aux robots est déconseillé. - Liens brisés.

Un nombre important de liens brisé est synonyme de site laissé à l'abandon. Les moteurs tiennent compte du fait qu'un site soit régulièrement maintenu, voir le brevet du score des pages de Google pour en avoir confirmation. Utilisez périodiquement un script de test de liens brisés car le Web évolue, les pages disparaissent ou changent d'adresse. - Absence de titre.

Les balises <title> sont essentielles, elle sont utilisées par les moteurs pour les pages de résultats. Elle doivent refléter le contenu de l'article sous une forme informative et non publicitaire.

La balise description est indispensable quand la page contient peu de texte et un contenu flash, images ou vidéos.

La balise keyword peut être omise car Google n'en tient pas compte comme cela est dit explicitement dans l'interview. - Répétition de titre.

Avoir le même titre sur toutes les pages, dans la balise <title> est très préjudiciable. C'est suffisant pour que les pages ne soient pas indexées comme on peut s'en apercevoir sur les forums pour webmasters. Avoir les mêmes mots-clés dans tous les titres est aussi à éviter. - Doorway ou satellite

Créer des pages spécialement pour les moteurs, avec des mots-clés choisis et un contenu sans intérêt, c'est ce que Google appelle les pages "Doorway". Cela est prohibé. Une page satellite est une page créée sur un autre domaine uniquement pour apporter des liens en quantité sur une domaine principal. C'est prohibé. - Echanges de liens et Liens réciproques

Google demande de ne pas faire d'échanges de liens ("link scheme") dans le but améliorer le PageRank du site.

S'inscrire sur des annuaires et leur fournir un lien réciproque n'est pas une chose à faire. On ne peut être pénalisé pour les liens vers son site même si l'annuaire est pénalisé, mais on le sera pour les liens sur un site pénalisé. Noter que tous les annuaires ne sont pas forcément pénalisés, seuls le sont ceux dont le contenu n'est pas modéré. - Suroptimisation.

La plupart des conseils que l'on peut donner à un webmaster pour faire que son contenu soit mieux indexé peuvent être perverti et utilisés de façon abusive, cela devient de la suroptimisation.

La plupart des conseils que l'on peut donner à un webmaster pour faire que son contenu soit mieux indexé peuvent être perverti et utilisés de façon abusive, cela devient de la suroptimisation.

- La page doit contenir tous les mots-clés qui sont pertinents, mais il a suroptimisation lorsqu'elle est bourrée de mots-clés destinés uniquement à faire venir le visiteur, sans apporter quoi que ce soit de nouveau. Les moteurs sont parfaitement capables de distinguer l'originalité et la pertinence d'une page.

On sur-optimise encore en utilisant les mêmes ancres de liens trop souvent sur le site, en plaçant les mêmes mot-clés dans le titre, dans l'URL, dans les ancres, les sous-titres, les balises alt, etc... - Les backlinks sont un moyen d'assurer la popularité d'un site. Il y a suroptimisation lorsque l'on crée soi-même des liens dans des annuaires sans visiteurs, dans les pages de forum, avec des ancres non naturelles et destinées manifestement aux moteurs. En fait le filtre Penguin est justement dirigé contre cela.

Les échanges de liens sont aussi des abus qu'il est facile de détecter pour les moteurs de recherche. - Les redirections peuvent être un procédé black hat. Quand on achète ou construit des sites dans le seul but de placer des liens vers le site principal, on déclenche encore un signal négatif.

- Les balises H1, H2 sont nécessaires pour organiser un texte et le rendre plus lisible. Elles sont prises en compte par les algos. Mais s'il y a trop de balises et pas assez de texte, c'est encore de la sur-optimisation. En fait les blogs ont maintenant tendance à faire des pages sans sous-titres de peur de suroptimiser, ce qui les rend en fait illisibles.

- On peut généraliser à tous les aspects du site. Est-il optimisé pour les visiteurs ou pour les moteurs?

- La page doit contenir tous les mots-clés qui sont pertinents, mais il a suroptimisation lorsqu'elle est bourrée de mots-clés destinés uniquement à faire venir le visiteur, sans apporter quoi que ce soit de nouveau. Les moteurs sont parfaitement capables de distinguer l'originalité et la pertinence d'une page.

- Redirection de domaine.

Rediriger un nom de domaine sur un autre avec une frame est une erreur. Il doit l'être avec une redirection 301.

Quand on redirige le contenu d'un domaine sur un autre, il convient de conserver la même structure de site et, c'est un conseil de Google, la même présentation. On pourra changer cette dernière ultérieurement. - Variables d'URL.

Avoir des variables dans une URL, sous la forme article.php?x=y n'empêche pas l'indexation, les CMS de forum le font couramment. Mais en avoir plusieurs peut empêcher l'indexation. Il est souvent admis qu'une variable nommée id ou ID empêche l'indexation car elle est vue comme une variable de session. - Double redirection.

Faire un lien sur une page d'un autre site, qui aboutit à une redirection sur la site de départ (cela peut arriver quand les sites sont fusionnés), aboutit immanquablement à la désindexation de la page qui contient le lien. - Simple redirection.

Il y a des actions tout a fait légitimes qui peuvent néanmoins amener un déclassement. Le déplacement de pages fréquent sur un site avec une redirection 301 en est un exemple. C'est une méthode qui est utilisée par les spammeurs: rediriger les visiteurs d'une page sur une autre pour récupérer le traffic. Quand vous réorganisez votre site et utilisez des directions 301 sur un contenu différent, ou même une mise en page différente, vous déclenchez un signal négatif qui provoque une pénalité. - Bloquer l'accès CSS et JavaScript aux robots

Si une directive dans robots.txt interdit aux crawlers de Google de parser les fichiers CSS et JavaScript, le site sera pénalisé, comme en ont fait l'expérience plusieurs sites importants qui ont perdu deux tiers de leurs visites, mais recouvré leur trafic une fois le blocage supprimé. C'est une pénalisation apparue en 2014.

Google veut pouvoir visualiser les pages comme le fait l'utilisateur, du fait que des directives ou scripts peuvent changer le contenu affiché.

Une dernière erreur: Oublier de lire les guidelines. Tout webmaster qui compte sur les services de Google pour améliorer le trafic de son site Web se doit de lire les conseils aux webmasters.

Conclusion

Bien que la liste semble longue, pour autant elle n'a rien de contraignant. Si l'on se concentre sur le contenu, il suffit de construire un site dans les règles pour qu'il obtienne la place qu'il mérite dans les résultats, en fonction de sa richesse et son originalité.

Voir aussi