Wikipedia et ses controverses

Wiki à vocation encyclopédique, réalisé bénévolement par des contributeurs anonymes, il propose une fiche sur quasiment tout sujet.

Principes: la connaissance open source

L'idée du wiki est l'application des principes de l’open source à l’encyclopédie et donc à la connaissance. A savoir, que dans un projet libre et utilisable gratuitement par tous, n’importe qui peut collaborer en apportant une pierre à l’édifice. La somme des contributions, même les plus modestes aboutit à une encyclopédie en ligne complète.

Les articles sont sous licence libre, ils appartiennent à tous et peuvent être placés sur n’importe quel site (attention cependant au duplicate content vis à vis des moteurs de recherche). L’hébergeur Wikipedia n’est qu’un simple serveur qui met à la disposition de la communauté les documents écrits par la communauté.

Wikipedia à ses lois, ses citoyens, lecteurs et contributeurs, une sorte d'administration, de police (contre les spam, rassurez-vous) de juges un peu partisans… Tout cela s’est développé en trois ans, en réaction aux problèmes qu’a connu l’encyclopédie.

Ce site à un abord plutôt aimable, avec sa gratuité, son ouverture aux contributions et ses articles nombreux quelquefois complets, souvent instructifs.

Evolution

Un changement radical sur une partie du wiki: toutes les contributions devront être vérifiées par un éditeur confirmé. C’est la fin de la politique de libre contribution de la part du public, et un pas fait dans la façon dont fonctionne Knol où les articles sont gérés par des auteurs, avec selon le choix des niveaux d’ouverture aux contributions différents.

Ce mode de fonctionnement est celui qui est adopté par la version allemande du wiki un an plus tôt. Il sera appliqué aux articles consacrés à des personnes, dans un premier temps et probablement étendu aux autres ensuite. Un mode de protection optionnel existait déjà pour les articles trop souvent spammés: il deviendra donc automatique.

Or une étude montre une nette récession de Wikipedia en terme d’éditions et de trafic, due à la main mise sur le site par les éditeurs anciens qui effacent souvent les contributions du public. La fondation Wikimedia avait réagit à ces résultats en ouvrant un groupe de réflexion. Avec cette nouvelle politique, elle renforce au contraire la tendance!

Les modifications faites par le public seront toujours possibles, mais elle ne seront pas présentées aux lecteurs. Il faudra qu’un éditeur enregistré et ayant un certain nombre de contributions valide les changements pour qu’ils soient affichés publiquement.

Cela certes devrait réduire le spam, mais non supprimer tous les défauts des articles. Ceux-ci ne seront plus mis à jour que de loin en loin et les articles qui ne sont pas suivis régulièrement par des éditeurs ne le seront plus du tout.

Désaffection

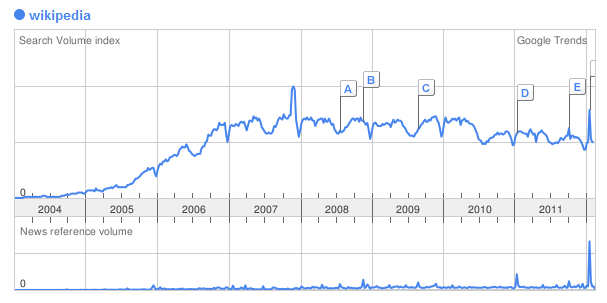

Et si l’on regarde l’évolution du trafic telle qu’elle est donnée par Google Trends, la même désaffection se manifeste de la part du public: les consultations stagnent de 2007 à 2009 et s’effritent peu à peu les années suivantes.

Pourquoi se détourne t-on du wiki qui a connu une progression continue jusqu’en 2007? La fondation Wikimedia refuse d’admettre que le site est en perte de vitesse. Son explication est que le site repose de plus en plus sur des experts plutôt que sur des contributeurs lambda, et donc que leur nombre devient naturellement plus restreint.

Selon Michael Peel qui s’est exprimé dans une interview au Times:

Wikipédia n’est absolument pas mourante. Elle a une licence libre, ce qui veut dire que le contenu qui a été inclut est là pour toujours.

Et Jimmy Wales, un des fondateurs, affirme également que le nombre d’éditeurs est stable. Les statistiques propres à Wikipedia n’affichent que 39 000 éditeurs pour la version anglaise , une baisse de 1500 sur l’année précédente.

L’article du Wall Street Journal se base sur les recherches de Felipe Ortega de Libresoft (Universitad Rey Juan Carlos à Madrid).

Selon lui, Wikipedia à perdu en Mars et Avril 23000 des 100 000 éditeurs de langue anglaise. Les statistiques de Wikipedia en affichaient 40000. La différence vient de ce que Ortega prend en compte tous les éditeurs, tandis que Wikimedia ne compte que ceux qui ont fait au moins 5 éditions. Les deux comptent les éditeurs inactifs.

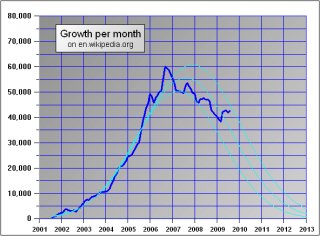

Non seulement le nombre d’articles créé par mois se réduit, mais aussi, le nombre mensuel de contributions (5,5 millions) et d’éditeurs différents – enregistrés ou non – (750 000), n’augmentent plus.

Cela inquiète la fondation Wikimedia qui a lancé une opération pour tenter de comprendre le phénomène.

La stagnation du renouvellement du contenu du site est cohérente avec la baisse de son audience car les moteurs de recherche donnent une place prépondérante aux articles récents.

Pourquoi les éditeurs quittent Wikipedia

Les éditeurs occasionnels deviennent apparemment objet d’ostracisme. 25% de leurs contributions sont effacées contre 10% quelques années auparavant. Ainsi, selon les chercheurs, les éditeurs anciens font acte de résistance envers les autres, ce qui tend à les décourager et contribue à faire baisser la qualité du contenu du site.

Il est décourageant pour les contributeurs de voir que le texte qu’ils ont ajouté sera supprimé ou modifié par d’autres éditeurs. Finalement, avec le temps, il n’en restera rien. Le principe même de la libre édition par chacun veut cela.

Pourquoi se donner du mal à écrire un texte de qualité qui disparaîtra inexorablement avec le temps?

On se plaint aussi de la bureaucratie, qui vient sans doute de la volonté d’avoir des éditeurs plus experts (assez compréhensible, du reste). Il est de plus en plus difficile de contribuer à cause de la somme de règles à suivre et des groupes d’éditeurs bien installés qui annulent les éditions des éditeurs occasionnels. Cette bureaucratie va encore s’accroître prochainement avec un contrôle strict par des groupes d’éditeurs sur les articles consacrés aux personnes.

Le dilemme

Wikipedia est face à un dilemme insoluble: conserver un site totalement ouvert pour profiter d’une plus grande activité et de mises à jour immédiates avec l’inconvénient d’une lutte incessante contre le spam, et d’un contenu souvent douteux, ou restreindre l’accès à des « experts ». Ceux-ci sont bénévoles et ne sont pas obligés de travailler pour le site, les mises à jour et corrections peuvent donc être délayées à jamais.

Et dans le second cas le site augmente quand au sérieux du contenu mais perd le soutien des internautes qui n’y contribuent plus.

Références

- Le rapport de l’équipe de Palo Alto. (Anglais).

Elle compare l’activité des éditeurs à une culture de microbes dont le nombre cesse de croître faute de nutriments. - Réponse de Wikimedia.

La guerre des moteurs de recherche

En décembre 2006 la nouvelle se répand que Wikipedia allait lancer son propre moteur de recherche pour concurrencer Google car les dirigeants de l’encyclopédie estimaient ce dernier un peu trop spammé par les webmasters et donc retournant des résultats peu pertinents. Le but était de remplacer les robots des moteurs de recherche par des humains (un progrès discutable, surtout quand le nombre de pages augmente exponentiellement).

Wikia search, le moteur humain

Annoncé sous le nom de Wikiasari (en hawaien, wiki signifie « rapide » et asari « cherche »), puis démenti, le moteur de recherche Wikia est lancé le 7 Janvier 2008 comme sous-domaine de Wikia.com.

Il transposait au moteur de recherche les principes qui sont à la base de Wikipedia et du site Answer de Yahoo: la contribution est permise à tous, le meilleur devant émerger de la masse des actions individuelles bien que comportant spams et vandalismes…

Le moteur utilisait le logiciel Grub racheté à la compagnie Looksmart qui avait fait fonctionner un projet similaire avant de revenir à un moteur robotisé. Grub a été créé en 2000.

Il utilisait aussi conjointenent Nutch, un moteur de recherche basé sur Lucene, un logiciel open source qui fournit le crawler, le parseur de pages HTML et autres services liés.

Search.wikia.org, redirige maintenant sur answers.wikia.org. Le moteur de recherche humain n'intéressait que les spammeurs!

Wikiseek

En Janvier 2007, la société SearchMe lance le moteur Wikiseek, destiné à remplacer le moteur de recherche interne à Wikipedia par quelque chose de plus efficace! Le nouveau moteur ressemble à celui de Google et utilise des robots.

Wikiseek est mort à la fin de 2008.

Conflits

National Portrait Gallery

La NPG a intenté à Wikipedia une action en justice, lui reprochantd'avoir mis en ligne environ 3000 images qu’elle avait digitalisées afin de les commercialiser.

Ces images sont dans le domaine public et donc Wikipedia s’estime en droit de les mettre en ligne et les utiliser pour ces articles.

Et le NPG a reçu l’appui d’un autre organisme, le BAPLA (British Association of Picture Libraries and Agencies) qui avance cet argument:

« The copying of original works for commercial use requires skill and expertise and has a financial cost to the producer. »

(Trad.: La reproduction d’un travail original pour un usage commercial requiert savoir faire et expertise et a un coût financier pour le producteur. )

En fait, un état de guerre persiste depuis des mois entre NPG et Wikipedia, les employés de la première étant systématiquement bannis par les équipes d’entretien de la seconde parce qu’ils suppriment sur Wikipédia les images digitalisées par leur entreprise. Ils sont identifiés selon leur adresse IP qui est celle de la NPG.

Que conclure? Faire son beurre avec le travail d’autrui (en l’occurrence des images qui sont dans le domaine public) est-il plus légitime que de l’offrir gratuitement à tous? Faire le commerce de ce qui appartient à tous est il plus juste que de rendre à tous ce qui leur appartient?

En fait la NPG se trouve de fait contrainte de pratiquer le bénévolat par les bénévoles de Wikipedia, ce qui est plutôt comique.

Elle a perdu le procès.

La scientologie

Wikipedia a décidé de bannir toutes les contributions venant d’adresses IP associées à l’église de scientologie, estimant que les contributions de membres de la secte (selon la France c’est une secte) avaient pour but de favoriser l’image de la Scientologie sans aucune objectivité.

Le principe de Wikipedia étant d’interdire les contributions visant à l’auto-promotion, ce qui revient souvent à interdire aux intéressés de répliquer quand on dit n’importe quoi sur leur compte (dans le domaine des biographies ou des entreprises), la Scientologie n’a donc pas le droit d’intervenir quand on parle d’elle.

En fait on estime chez Wikipedia que des quantités de personnes utilisent les ordinateurs de la secte sans que l’on puisse identifier les faux-nez utilisant le même ordinateur avec des comptes différents, ce qui motive en partie la décision de bannir toutes les IP. D’autant que ces éditeurs ne semblent concernés que lorsqu’on parle de la Scientologie.

Il ne reste plus qu’aux membres à attendre l’intervention de Xenu… ou utiliser des proxies!

- Référence: The Register.

Department of Justice

Le département de la justice américain a été banni par Wikipedia après qu’une personne utilisant son adresse IP ait tenté de modifier plusieurs articles. Référence: The Register.

Barbara Bauer

Wikipedia a souvent été l’objet de plainte en diffamation. Dans l’article qui lui est consacré sur le Wiki, l’agent littéraire Barbara Bauer se voit qualifiée de: « Dumbest of the twenty worst agents » (la plus bête des vingt pires agents).

On appréciera la qualité encyclopédique de l’article. Wikipedia se retranche derrière le premier Amendement qui garantit la liberté d’expression, et la loi du New Jersey. Elle est soutenue par l’EFF, (Electronic Frontier Foundation), une association pour la liberté d’expression sur Internet.

Elle déclare que les plaignants devraient engager des poursuites contre les auteurs de ces propos plutôt que contre les sites collaboratifs qui les publient. Mais l’anonymat des contributions rend de telles poursuites plutôt difficiles!

Barbara Bauer aurait déjà déposé plusieurs plaintes contre des sites Internet, et fait fermer le site Absolute Write.

Finances

Les caisses sont alimentées essentiellement par une campagne annuelle d'appel aux donations. Les dépenses couvrent les coûts des serveurs et surtout les salaires de 300 personnes. Notons que le contenu est réalisé uniquement par des bénévoles.

| Année | Donations | Dépenses | Bénéfice cumulé |

|---|---|---|---|

| 2003/2004 | $80,129 | $23,463 | $56,666 |

| 2004/2005 | $379,088 | $177,670 | $268,084 |

| 2005/2006 | $1,508,039 | $791,907 | $1,004,216 |

| 2006/2007 | $2,734,909 | $2,077,843 | $1,658,282 |

| 2007/2008 | $5,032,981 | $3,540,724 | $5,178,168 |

| 2008/2009 | $8,658,006 | $5,617,236 | $8,231,767 |

| 2009/2010 | $17,979,312 | $10,266,793 | $14,542,731 |

| 2010/2011 | $24,785,092 | $17,889,794 | $24,192,144 |

| 2011/2012 | $38,479,665 | $29,260,652 | $34,929,058 |

| 2012/2013 | $48,635,408 | $35,704,796 | $45,189,124 |

| 2013/2014 | $52,465,287 | $45,900,745 | $53,475,021 |

| 2014/2015 | $75,797,223 | $52,596,782 | $77,820,298 |

| 2015/2016 | $81,862,724 | $65,947,465 | $91,782,795 |

Répartition des dépenses en dollars en 2016 selon Wikipedia:

| Categorie | Affectation |

|---|---|

| Salaires | 31,713,961 |

| Récompenses | 11,354,612 |

| Hébergement internet | 2,069,572 |

| Dépenses courantes internes | 1,065,523 |

| Gestion des donations | 3,604,682 |

| Dépenses de services professionnels | 6,033,172 |

| Autres dépenses de gestion | 4,777,203 |

| Voyages et conférences | 2,296,592 |

| Dépréciation et ammortissements | 2,720,835 |

| Dépenses spéciales d'évènements. | 311,313 |

| Total des dépenses. | 65,947,465 |

La "gestion des donations" ou les "voyages" coûtent chacun cher que les serveurs qui affichent 16 milliards de pages vues par mois en 2016! (Source)

Mediawiki

L’encyclopédie libre utilise une version modifiée du logiciel Mediawiki, réalisé pour elle à l’origine. Ce logiciel est utilisé aussi sur des sites personnels.

Il permet l’édition des pages et la gestion des comptes d’éditeur, ainsi que des archives et des historiques d’édition.

Description

A chaque page est associée une page de discussion dont le format est similaire à celui de l’article. En fait le wiki tout entier repose sur le même format de page. Il permet cependant d’importer des images pour égayer un peu l’austérité de ce contenu textuel. Il y a un coté récursif dans la conception: un article a une page de discussion et un historique, la page de discussion a une page de discussion et un historique…

L’édition des articles se fait dans une sorte de dialecte similaire au bbCode, avec insertion de balises CSS assez complexes pour faire quelque chose d’aussi extraordinaire que l’ajout d’une image. Pourtant le wysiwyg est assez répandu sur les CMS. Il existe d’ailleurs des extensions wysiwyg à Mediawiki mais vous n’y trouverez aucune allusion sur Wikipedia.

Sur un autre plan, des outils additionnels ont été développés pour combattre le vandalisme mais requièrent une activité constante des éditeurs.

Limitations

En fait le logiciel exploite le coté hypertexte du Web classique et n’emploie aucune des innovations techniques propres au Web 2.0.

Quand on compare l’importance du trafic du site avec le logiciel Mediawiki qui le gère, et même en tenant compte des extensions qui lui ont été apportées pour Wikipedia, on a l’impression d’un paquebot propulsé par le moteur d’une maquette avec une hélice de 3 cm de longueur. A coté de cela il faut 10000 nageurs pour pousser l’engin en battant des palmes, c’est à peu près le nombre d’ « administrateurs » du site!

Même si MediaWiki, est considéré comme un CMS, cela reste un outil extrêmement primaire, qui se borne à mettre en ligne les textes bruts rédigés collectivement. Aucun traitement n’est accompli sur ces données, tandis qu’un CMS moderne est capable de fabriquer des pages multiples répondant à des demandes diverses, à partir d’une base de données.

Le projet pourrait donc évoluer positivement dans deux directions, celle du contenu avec un logiciel wiki plus perfectionné (plus Web 2.0) et celle d’une meilleure organisation des contributions.

Wikidashboard et WikiScanner

Pour analyser les contributions des éditeurs à un article sur Wikipedia, et révéler notamment lorsque l’essentiel des contributions est faite par un seul éditeur qui peut ainsi influencer son contenu, des chercheurs on créé un outil, le Wikidashboard.

Cet outil fournit pour un article donné, les indications suivantes:

- Quels utilisateurs ont le plus d’éditions.

- Quels pourcentage d’éditions revient à un éditeur sur une page.

- Quelle est l’implication d’un éditeur sur d’autres articles.

- Quelle est l’activité sur une page.

Il veut ainsi compenser les faiblesses du système instauré par l’organisation, qui se contente de marquer une page comme « sujet à contreverse », ce qui n’engendre pas forcément les corrections nécessaires.

Mais quand on connaît les éditeurs anonymes de Wikipedia, on peut déjà deviner comment les résultats de l’outil seront eux aussi manipulés avec des éditions en série superficielles sur les articles…

Wikidashboard est l’oeuvre de Ed Chi, du centre de recherche de Palo Alto.

Ce site rappelle que Wales lui-même, le fondateur de Wikipedia, met en garde les utilisateurs sur le fait que le contenu du wiki ne devrait pas être utilisé par les étudiants, ni pour des recherches sérieuses.

Le WikiScanner est un autre outil, open source, et créé en 2007 par Virgil Griffith qui analyse des informations sur les éditeurs non enregistrés tels que l'IP et utilise ces données pour confondre les organisations qui éditent les articles les concernant pour se donner une image plus favorable. Parmi la liste de ces "manipulateurs" on trouve: le FBI, la CIA, le Vatican, l'église de scientologie, les nations unies, Microsoft et Apple, et de nombreux partis politiques!

Même si cela enfreint le règlement du site, ces contribution peuvent avoir pour but de corriger des erreurs et pas forcément de camoufler des vérités gênantes.

Autres outils et documents

Marque-page de l’encyclopédie

Les pages utiles sur Wilkipedia. Notez que les balises de liens externes <a> ont l’attribut rel= »nofollow » ce qu’il faut toujours faire en retour de la politique nofollow de Wikipedia, pour le respect des règles d’éthique du Web.

- Le forum, que l’on appelle « le bistro ».

- Requête à un administrateur. Bloquer un vandale, par exemple.

- Chartre des liens externes. Les règles permettant d’ajouter un lien vers un site.

- Commons. Images, photos, médias divers non propriétaires et librement utilisables.

Outils

- Wikidata. Cette base de donnée de connaissances intéressera les développeurs Web, car elle peut être utilisée par tout site Web et fournir des informations mises à jour continuellement, telles que la population d'une ville. En avril 2013, il y a 12 millions d'éléments.

- Statistiques. Tableau statistique du nombre d’articles par pays.